La minería de datos y el análisis de datos son dos disciplinas esenciales en el mundo del Big Data que permiten descubrir patrones, tendencias y conocimientos ocultos en grandes conjuntos de datos. Ambas técnicas son fundamentales para aprovechar el valor y el potencial que los datos ofrecen en diversas áreas, desde negocios hasta ciencia y más allá.

Minería de Datos

La minería de datos es el proceso de descubrir patrones significativos y relaciones útiles en grandes conjuntos de datos. Utiliza técnicas de aprendizaje automático, estadísticas y algoritmos para identificar información valiosa que puede ser utilizada para tomar decisiones informadas y estratégicas.

Los pasos principales en el proceso de minería de datos son:

Recopilación de Datos: Se recolectan los datos de diversas fuentes, como bases de datos, registros, sensores y más.

Preparación de Datos: Los datos se limpian, se transforman y se preparan para el análisis, lo que incluye eliminar datos duplicados, tratar valores faltantes y normalizar los datos.

Procesamiento de Datos: Se aplican algoritmos y técnicas de minería de datos para descubrir patrones y relaciones en los datos.

Evaluación de Resultados: Se evalúan los resultados para determinar su relevancia y significado en el contexto del problema que se está abordando.

Interpretación y Utilización: Se interpretan los resultados para tomar decisiones o realizar acciones basadas en los conocimientos obtenidos.

La minería de datos se aplica en diversas áreas, como marketing, finanzas, medicina, manufactura y más, para realizar análisis de mercado, detección de fraudes, segmentación de clientes y otros usos importantes.

Análisis de Datos

El análisis de datos es el proceso de examinar, limpiar y modelar datos con el objetivo de obtener información significativa y valiosa. Es una disciplina amplia que incluye diferentes técnicas y métodos para comprender mejor los datos y extraer conocimientos relevantes.

Los pasos comunes en el proceso de análisis de datos son:

Exploración de Datos: Se examinan los datos para entender su estructura, distribución y características.

Limpieza de Datos: Se tratan los datos faltantes, valores atípicos y errores en los datos para mejorar su calidad.

Análisis Descriptivo: Se utilizan técnicas estadísticas y visuales para resumir y describir los datos.

Análisis Inferencial: Se realizan inferencias y conclusiones sobre poblaciones más grandes basadas en muestras de datos.

Modelado de Datos: Se aplican modelos matemáticos o estadísticos para hacer predicciones o tomar decisiones basadas en los datos.

El análisis de datos es una parte crucial en el proceso de toma de decisiones y en la resolución de problemas en diversos campos, como negocios, investigación científica, gobierno, entre otros.

Aplicaciones y Beneficios

Tanto la minería de datos como el análisis de datos tienen una amplia gama de aplicaciones y beneficios:

Optimización de procesos y operaciones empresariales.

Identificación de patrones de comportamiento de clientes para la personalización de servicios.

Detención de fraudes y anomalías en transacciones financieras.

Predicciones y pronósticos para mejorar la planificación y toma de decisiones.

Descubrimiento de nuevos medicamentos y avances en la investigación científica.

Análisis de datos de sensores para monitoreo y control de sistemas.

Resumen

La minería de datos y el análisis de datos son pilares fundamentales en el mundo del Big Data. Estas disciplinas permiten convertir grandes volúmenes de datos en conocimientos valiosos que impulsan el crecimiento, la innovación y la mejora en diversos sectores. La comprensión y utilización adecuada de estas técnicas son esenciales para aprovechar todo el potencial que los datos ofrecen en la era digital.

Minería de Datos

La minería de datos es una disciplina que se enfoca en descubrir patrones, tendencias, relaciones y conocimientos significativos en grandes conjuntos de datos. Es una parte esencial del proceso de análisis de datos en el mundo del Big Data, ya que permite extraer información valiosa y tomar decisiones informadas en diversas áreas, desde negocios hasta ciencia y más allá.

Proceso de Minería de Datos

El proceso de minería de datos se compone de varias etapas interrelacionadas:

Recopilación de Datos: Se recolectan los datos de diversas fuentes, como bases de datos, registros, sistemas en tiempo real, redes sociales, entre otros.

Limpieza de Datos: Los datos pueden contener errores, valores faltantes o duplicados. En esta etapa, se realizan tareas de limpieza y transformación para asegurar la calidad y consistencia de los datos.

Exploración de Datos: Se analizan los datos para entender su estructura, distribución y características. La visualización de datos es una herramienta útil para identificar patrones iniciales.

Preparación de Datos: Los datos se seleccionan y se formatean para su procesamiento en las etapas siguientes. Esto puede incluir la selección de atributos relevantes y la creación de nuevas variables.

Modelado de Datos: Se aplican algoritmos y técnicas de minería de datos para descubrir patrones y relaciones en los datos. Esto puede incluir técnicas de aprendizaje automático, análisis estadístico y minería de texto.

Evaluación de Resultados: Se evalúan los resultados obtenidos para determinar su relevancia y significado en el contexto del problema que se está abordando.

Interpretación y Utilización: Los conocimientos extraídos de la minería de datos se interpretan para tomar decisiones informadas y llevar a cabo acciones en función de los resultados obtenidos.

Algoritmos de Minería de Datos

Existen numerosos algoritmos utilizados en la minería de datos, cada uno con sus propias características y aplicaciones:

Árboles de Decisión: Son estructuras de árbol que se utilizan para clasificar y predecir datos.

Regresión: Se utiliza para modelar la relación entre variables y hacer predicciones numéricas.

Agrupamiento (Clustering): Agrupa datos similares en categorías o grupos basados en sus similitudes.

Redes Neuronales: Modelan el comportamiento del cerebro humano para resolver problemas complejos.

Máquinas de Soporte Vectorial (SVM): Se utiliza para clasificación y regresión, particularmente en problemas con múltiples atributos.

Apriori: Se utiliza para descubrir asociaciones y patrones frecuentes en conjuntos de transacciones.

Naive Bayes: Utilizado para problemas de clasificación y basado en el teorema de Bayes.

K-Vecinos Más Cercanos (KNN): Se utiliza para clasificación y se basa en la proximidad de los datos a otros vecinos.

Aplicaciones de Minería de Datos

La minería de datos tiene una amplia gama de aplicaciones en diversos campos:

Segmentación de clientes para campañas de marketing personalizadas.

Detección de fraudes y anomalías en transacciones financieras.

Optimización de procesos de producción y operaciones empresariales.

Predicción de la demanda y planificación de inventarios.

Análisis de sentimientos en redes sociales para medir la satisfacción del cliente.

Descubrimiento de patrones de compra para recomendaciones de productos.

Diagnóstico médico y predicción de enfermedades.

Análisis de datos geoespaciales para optimización de rutas y logística.

Resumen

La minería de datos es una herramienta poderosa para extraer conocimientos valiosos de grandes volúmenes de datos. Su aplicación se extiende a una amplia variedad de sectores, desde negocios hasta ciencia y salud. Comprender los conceptos y algoritmos de minería de datos es fundamental para aprovechar todo el potencial de los datos y tomar decisiones más informadas y efectivas en el mundo actual del Big Data.

Técnicas de Minería de Datos: Clasificación, Agrupamiento, Reglas de Asociación

En el campo de la minería de datos, existen diversas técnicas que se utilizan para descubrir patrones y conocimientos significativos en grandes conjuntos de datos. Algunas de las técnicas más comunes son la clasificación, el agrupamiento y las reglas de asociación.

Clasificación

La clasificación es una técnica de minería de datos que se utiliza para categorizar objetos o instancias en clases predefinidas. Es una forma de aprendizaje supervisado, donde se entrena un modelo con un conjunto de datos etiquetado (datos con clases conocidas) para que pueda predecir la clase de nuevos datos no etiquetados.

El proceso de clasificación implica los siguientes pasos:

Selección de Atributos: Se eligen los atributos relevantes que se utilizarán como características para clasificar los datos.

Entrenamiento del Modelo: Se utiliza un algoritmo de clasificación para aprender de los datos etiquetados y construir un modelo predictivo.

Evaluación del Modelo: Se evalúa la precisión del modelo utilizando datos no etiquetados o un conjunto de prueba independiente.

Aplicación del Modelo: El modelo entrenado se utiliza para predecir la clase de nuevos datos no etiquetados.

La clasificación es ampliamente utilizada en diversas aplicaciones, como detección de spam en correos electrónicos, diagnóstico médico, clasificación de clientes para segmentación de mercado, entre otros.

Agrupamiento (Clustering)

El agrupamiento es una técnica de minería de datos que se utiliza para agrupar objetos similares en categorías o clusters, donde los objetos dentro de un mismo grupo son más similares entre sí que con los objetos de otros grupos. Es una forma de aprendizaje no supervisado, ya que no se utilizan etiquetas en el proceso de agrupamiento.

El proceso de agrupamiento implica los siguientes pasos:

Selección de Atributos: Se eligen los atributos relevantes que se utilizarán para medir la similitud entre los objetos.

Definición de Métricas de Similitud: Se definen métricas o medidas de distancia para calcular la similitud entre los objetos.

Creación de Clusters: Los objetos se agrupan en clusters según su similitud medida por las métricas definidas.

Evaluación del Agrupamiento: Se evalúa la calidad de los clusters formados utilizando índices de evaluación.

El agrupamiento es utilizado en diversas aplicaciones, como segmentación de clientes, análisis de patrones de tráfico en redes, agrupamiento de genes en bioinformática, entre otros.

Reglas de Asociación

Las reglas de asociación son una técnica de minería de datos que se utiliza para descubrir patrones frecuentes en conjuntos de datos transaccionales. Estos patrones se presentan en forma de reglas que indican la relación entre diferentes elementos o atributos.

El proceso de descubrimiento de reglas de asociación implica los siguientes pasos:

Generación de Conjuntos de Frecuencia: Se obtienen los conjuntos de elementos frecuentes en el conjunto de datos.

Generación de Reglas: A partir de los conjuntos de frecuencia, se generan reglas de asociación que indican la relación entre diferentes elementos.

Aplicación de Medidas de Confianza: Se aplican medidas de confianza y soporte para evaluar la fortaleza de las reglas.

Selección de Reglas Relevantes: Se seleccionan las reglas más relevantes y significativas basadas en las medidas de confianza y soporte.

Las reglas de asociación son ampliamente utilizadas en aplicaciones como recomendación de productos, análisis de carritos de compra en tiendas minoristas, detección de fraudes en tarjetas de crédito, entre otros.

Resumen

Las técnicas de minería de datos, como la clasificación, el agrupamiento y las reglas de asociación, son fundamentales para descubrir conocimientos valiosos en grandes conjuntos de datos. Cada técnica tiene sus propias características y aplicaciones, y su uso adecuado puede proporcionar información valiosa para la toma de decisiones en diversas áreas y sectores.

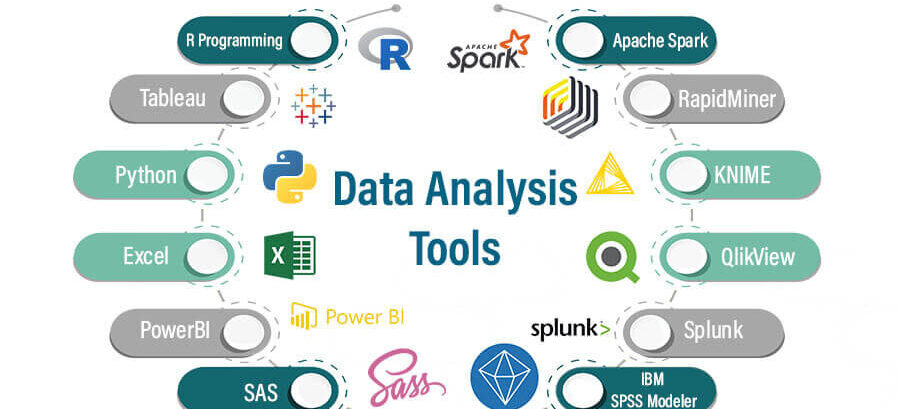

Herramientas de Análisis de Datos

El análisis de datos es una disciplina esencial en el mundo actual del Big Data, donde grandes volúmenes de información se generan y recopilan en diversas industrias y sectores. Para realizar un análisis efectivo, se requiere el uso de herramientas adecuadas que faciliten la manipulación, visualización y obtención de conocimientos valiosos a partir de los datos.

Herramientas de Análisis de Datos

Existen varias herramientas de análisis de datos disponibles en el mercado, cada una con sus propias características y capacidades. A continuación, se presentan algunas de las herramientas más populares:

Microsoft Excel

Microsoft Excel es una herramienta ampliamente utilizada para el análisis de datos. Es un programa de hojas de cálculo que permite realizar tareas básicas de análisis, como filtrado, ordenamiento, cálculos y gráficos. Es ideal para usuarios principiantes que deseen realizar análisis sencillos.

SQL

SQL (Structured Query Language) es un lenguaje de consulta utilizado para interactuar con bases de datos relacionales. Permite realizar consultas complejas para extraer, modificar y analizar datos almacenados en una base de datos. Es especialmente útil para analizar grandes volúmenes de datos estructurados.

Tableau

Tableau es una herramienta de visualización de datos que permite crear informes y gráficos interactivos a partir de diferentes fuentes de datos. Es ampliamente utilizada para crear paneles de control y presentaciones visuales para el análisis de datos.

Python

Python es un lenguaje de programación versátil que cuenta con bibliotecas poderosas para el análisis de datos, como NumPy, Pandas y Matplotlib. Es utilizado por científicos de datos y analistas para realizar análisis estadísticos y visualizaciones avanzadas.

R

R es un lenguaje de programación especializado en estadísticas y análisis de datos. Es ampliamente utilizado en la comunidad académica y de investigación. Ofrece una amplia variedad de paquetes para el análisis de datos y la creación de gráficos.

Apache Spark

Apache Spark es un marco de trabajo para el procesamiento y análisis de datos a gran escala. Es especialmente útil para el procesamiento distribuido de grandes conjuntos de datos y se utiliza para realizar análisis complejos y procesamiento de datos en tiempo real.

KNIME

KNIME es una plataforma de análisis de datos de código abierto que ofrece una interfaz gráfica para diseñar flujos de trabajo de análisis de datos. Permite la integración de diferentes herramientas y algoritmos para el procesamiento y análisis de datos.

Selección de la Herramienta

La elección de la herramienta de análisis de datos depende de diversos factores, como la complejidad del análisis requerido, el tamaño de los datos, las necesidades de visualización y la experiencia del usuario. Es importante evaluar las características y capacidades de las herramientas disponibles para seleccionar la más adecuada para el análisis de datos específico.

Resumen

Las herramientas de análisis de datos son fundamentales para aprovechar el potencial de los grandes volúmenes de datos que se generan en el mundo actual. Cada herramienta tiene sus propias ventajas y aplicaciones, y es importante elegir la que mejor se adapte a las necesidades del análisis a realizar. Con estas herramientas, los analistas pueden realizar tareas complejas y obtener conocimientos valiosos que impulsan la toma de decisiones informadas y estratégicas en diversas áreas y sectores.

Uso de Bases de Datos para Análisis de Grandes Volúmenes de Datos

En el mundo actual, la cantidad de datos generados y recopilados ha alcanzado niveles sin precedentes. Desde redes sociales hasta sensores en dispositivos inteligentes, cada interacción y evento produce una gran cantidad de información. Para extraer conocimientos valiosos y tomar decisiones informadas, se requiere una infraestructura de datos sólida que pueda manejar grandes volúmenes de información de manera eficiente. En este contexto, el uso de bases de datos juega un papel fundamental.

Características de las Bases de Datos para Grandes Volúmenes de Datos

Las bases de datos diseñadas para el análisis de grandes volúmenes de datos deben tener ciertas características para garantizar el rendimiento y la escalabilidad:

Alta Capacidad de Almacenamiento: Las bases de datos deben poder almacenar y gestionar grandes cantidades de datos sin afectar su rendimiento.

Alta Velocidad de Procesamiento: Deben ser capaces de procesar consultas complejas de manera rápida y eficiente.

Escalabilidad Horizontal: Deben poder crecer horizontalmente agregando más nodos o servidores para manejar el aumento del volumen de datos.

Paralelismo: Deben poder realizar operaciones en paralelo para acelerar el procesamiento.

Optimización de Consultas: Deben contar con un optimizador de consultas que seleccione la mejor estrategia de ejecución para las consultas.

Tolerancia a Fallos: Deben ser resistentes a fallos y contar con mecanismos de recuperación.

Soporte para Estructuras de Datos No Estructurados: Deben poder manejar diferentes tipos de datos, como texto, imágenes y vídeos.

Tecnologías de Bases de Datos para Grandes Volúmenes de Datos

Existen varias tecnologías de bases de datos diseñadas específicamente para el análisis de grandes volúmenes de datos. Algunas de las más populares son:

Bases de Datos Relacionales

A pesar de que las bases de datos relacionales no fueron originalmente diseñadas para grandes volúmenes de datos, han evolucionado para manejar grandes conjuntos de información. Tecnologías como MySQL, PostgreSQL y Microsoft SQL Server han implementado técnicas de particionamiento y optimización para mejorar su rendimiento en entornos de Big Data.

Bases de Datos NoSQL

Las bases de datos NoSQL son especialmente adecuadas para el análisis de grandes volúmenes de datos no estructurados. Entre las opciones más populares se encuentran:

Bases de Datos Documentales: Como MongoDB, que almacenan datos en documentos JSON.

Bases de Datos de Grafos: Como Neo4j, que almacenan datos en nodos y relaciones.

Bases de Datos Clave-Valor: Como Redis y Apache Cassandra, que almacenan datos como pares clave-valor.

Plataformas de Big Data

Estas plataformas están diseñadas específicamente para el procesamiento y análisis de grandes volúmenes de datos. Algunas de las más populares son:

Apache Hadoop: Un ecosistema que incluye el sistema de archivos distribuido HDFS y el paradigma de programación MapReduce para el procesamiento distribuido de datos.

Apache Spark: Un motor de procesamiento en memoria que permite el análisis de datos en tiempo real y en lote.

Apache Flink: Un sistema de procesamiento de datos en streaming y en lotes.

Aplicaciones del Análisis de Grandes Volúmenes de Datos

El análisis de grandes volúmenes de datos tiene aplicaciones en diversos sectores:

Empresas: Se utiliza para el análisis de ventas, optimización de operaciones, detección de fraudes y análisis de comportamiento del cliente.

Ciencia y Salud: Se aplica en investigación científica, análisis genómico, diagnóstico médico y análisis de datos biomédicos.

Medios y Entretenimiento: Se utiliza para la personalización de contenidos, análisis de audiencias y recomendaciones de productos y servicios.

Transporte y Logística: Se aplica en el seguimiento de activos, optimización de rutas y análisis de datos de sensores.

Gobierno y Sector Público: Se utiliza para el análisis de datos demográficos, planificación urbana y seguridad pública.

Resumen

El análisis de grandes volúmenes de datos es una disciplina esencial en el mundo actual. Las bases de datos diseñadas para manejar grandes conjuntos de información y las tecnologías de Big Data permiten obtener conocimientos valiosos y tomar decisiones informadas en diversos sectores. Con el crecimiento continuo de los datos, el análisis de grandes volúmenes de datos seguirá siendo una área clave para el progreso y la innovación.